Помощник

| Дата поста: | В теме: | За сообщение: | Поблагодарили: | ||

|---|---|---|---|---|---|

| 18.1.2020, 11:37 |

BERT – крупнейшее обновление Google. Как оптимизировать ваш сайт под BERT. |

BERT - это нейросеть, созданная Google в 2018 году и уже доказавшая преимущества в ряде практических задач. Используя её можно решать целый ряд задач: анализировать текст, отвечать на вопросы, создавать переводчики, выявлять спам, создавать системы предиктивного ввода текста и т.д. В октябре 2019 года Google добавила нейронную сеть BERT в ядро алгоритмов поиска Google для английского языка, а в декабре – для более чем 70 языков. Новое обновление поиска получило название BERT и затронуло 10% всех поисковых запросов.  1. BERT - нейронная сеть, созданная Google Научить компьютеры понимать естественный текст, как это делает человек, является интересной и крайне сложной задачей. Ведь в естественном языке много нюансов, разобраться в которых с трудом могут даже люди. В информатике есть целый подраздел Natural Language Processing (далее – NLP) – методы обработки естественного языка. NLP позволяет применять алгоритмы машинного обучения для текста и речи. Сегодня у многих из нас есть смартфоны с распознаванием речи – в них используется именно NLP. Также, многие люди используют ноутбуки и компьютеры со встроенным в ОС распознаванием речи. Итак, в 2018 году Google анонсирует новейшую нейронную сеть BERT (Bidirectional Encoder Representations from Transformers). BERT использует Transfer learning (трансферное обучение), что позволяет использовать его основную языковую модель, дополнительно обучив её под свои конкретные задачи, самым разнообразным компаниям. Это означает, что обучение нейронной сети происходит в два этапа. Сначала долго и дорого её обучают на огромном корпусе в миллиарды слов (это называется pre-training). На втором этапе сеть можно быстро дообучить под разные задачи. Ранее, одним из основных инструментов претренинга было нечто вроде словаря, использующего векторное представление слов, описывавших связи между словами в виде цифр. Однако прошедшая претренинг на векторном словаре нейросеть не понимала смысл слов. С её точки зрения, предложения «человек укусил собаку» и «собака укусила человека» идентичны. В Google разработали уникальную систему претренинга для обеспечения нейросети более богатыми правилами – не только словарём, но и синтаксисом с контекстом. Исследователи начали обучать нейросети на более общей задаче под названием языковое моделирование, скармливая нейросетям огромные объёмы текста – миллиарды слов, расставленных в грамматически корректные предложения. После этого нейросеть должна уметь предсказать следующее слово в тексте самостоятельно. По сути, BERT состоит из трех важнейших составляющих. Во-первых - это прошедшая претренинг языковая модель. Во-вторых – возможность решить, какие из особенностей предложения являются наиболее важными. В-третьих, в отличие от других прошедших претренинг языковых моделей, созданных посредством обработки нейросетями терабайтов текста, читаемого слева направо, модель BERT читает и справа налево, и одновременно слева направо, и обучается предсказывать, какие слова случайным образом были исключены из предложений. Каждый из трёх этих составляющих – глубокая модель языка с претренингом, внимание и двунаправленность – существовали до BERT по отдельности. Но до тех пор, пока Google не выпустил свой алгоритм в конце 2018 года, никто не скомбинировал их таким успешным образом. 2.Внедрение BERT в основной алгоритм поиска Google В октябре 2019 года Google «выкатил» обновление ядра алгоритмов поиска под названием BERT. Отныне, одноименная нейросеть будет работать в качестве составляющего ядра алгоритмов поиска. По заверению Google - это крупнейшее обновление ядра со времен RankBrain. Многие вебмастера не заметили скачков трафика после внедрения нового алгоритма, хотя Google заверяет, что оно коснулось 10% всех поисковых запросов. Чтобы понять, почему вебмастера не ощутили значительных колебаний трафика, еще раз рассмотрим как работает BERT и на какие запросы он влияет. Типичный вебмастер, в основном, сфокусирован на СЧ или даже ВЧ запросы, которые достаточно коротки (1-3 слово). BERT сфокусирован на обработке длинных запросов. Именно поэтому большинство вебмастеров пока не замечают колебания, которое оказал BERT на выдачу. Итак, BERT лучше понимает и интерпретирует НЧ и микро-НЧ запросы, длинный хвост запросов. В частности, - это могут подтвердить дорвейщики, которые ощутили резкие колебания трафика и некоторые вебмастера, плотно работающие с 3-5-словниками, что характерно для продуктовых партнерок, например работающих под Amazon. Необходимо понимать, что BERT – это не фактор ранжирования. Непосредственно на ранжирование органической выдачи она не влияет. Однако, нейросеть позволяет Google лучше интепретировать запросы пользователей, лучше понимать интент. Именно это может достаточно сильно повлиять на Ваш трафик, после дальнейшего обучения нейросети. Если вы не заметили значительных флуктуаций в выдаче, это не означает, что их не было. Вы просто их не искали. 3. Как найти запросы, на которые повлиял BERT и как оптимизировать сайты под них Методика поиска запросов, на которые оказал влияние алгоритм BERT – достаточно стандартна и я расписывал её неоднократно за последние несколько лет. Смотрите например в статье про YMYL в разделе «Как найти некачественный контент на сайте». Еще один способ есть непосредственно в разделе статьи про BERT, где ищем запросы, используя Search Console. В целом алгоритм очень прост. Для поиска запросов, на которые оказал влияние BERT можно использовать Google Analytics или Google Search Console. Даты релиза алгоритма нам известны - 21 октября 2019 для англоязычных и 9 декабря для русскоязычных сайтов. Отсчитываем 3-4 недели после даты релиза (можно и больше) и сравниваем его с аналогичным предыдущим периодом. Для поиска используем каналы (органическую выдачу Google). И далее строим разрез по ключевым словам. Нам интересны запросы, которые существовали в предыдущем периоде, а в новом периоде (после внедрения алгоритма) не имеют показов. Так мы найдем утерянные запросы. Отсортировав результат по отсутствующим в предыдущем периоде и появившемся в новом (после релиза ядра алгоритмов), мы увидим, какие запросы появились, как теперь Google осмысляет контент. Если в указанный период на сайт добавлялся контент, то запросы, подходящие новому контенту необходимо исключить из анализа. Получив список запросов можно приступать к оптимизации вашего сайта. Как известно, сотрудники Google утверждают, что оптимизация под BERT - невозможна. Об этом высказался и Дэнни Салливан и Джон Мюллер. «Запросы не являются чем-то, на что вы можете повлиять в плане SEO», – сообщил Мюллер. «Если есть что-то, что вы можете сделать для оптимизации под алгоритм BERT, так это убедиться, что на ваших страницах естественный текст… Вместо того, чтобы использовать как можно больше ключевых слов, пишите естественно». Не густо, не правда-ли? Итак, чтобы «оптимизировать» под алгоритм BERT, рекомендую изучить ваш набор данных по приобретенным и потерянным ключевым словам и провести традиционную оптимизацию контента, чтобы улучшить или восстановить позиции запросов. Сначала вам нужно определить ключевые слова, которые вы потеряли после обновления BERT и заняться редакцией контента для их восстановления. При этом вовсе не нужно добавлять в контент эти поисковые запросы. Иногда достаточно добавить несколько предлогов и перефразировать пару предложений. В случае «пропажи» запросов, скорее всего страница перестала ранжироваться из-за «смещения акцентов» в смысле контента, совсем как в примере про преподавателя и студента. Обновление BERT помогает Google лучше понимать семантику (значение слов и фраз). Это означает, что если вы ранее ранжировались по фразе с длинным хвостом, но потеряли позиции после внедрения BERT, то, вероятно, страница соответствовала ключевым словам в запросе, но на самом деле не соответствовала цели поиска (интенту). Необходимо добавить смысла тем фразам и акцентировать внимание на тех словах, которые соответствуют интенту пользователя. Говоря попросту, ранее страница незаслуженно ранжировалась по утерянным запросам. Новый алгоритм BERT помог Google это понять. Вам придется немного постараться, обновляя контент, чтобы вернуть утерянные запросы. Улучшайте ваш контент и для тех ключей, которые появились после обновления BERT. Изучите, что именно пишут конкуренты и как они расставляют акценты в своих текстах. Используйте идеи конкурентов, чтобы сделать свой контент более «ценным», чем у них. Необходимо отвечать на конкретные запросы в своем контенте лучше, чем конкуренты. Огромное количество способов оптимизации приведено в моей книге «SEO Монстр 2020». На более чем 700 страницах раскрыты все важнейшие факторы ранжирования и методы воздействия на них с практическими примерами. Хороший рост показали информационные сайты, построенные по SILO-структуре. Здесь изолированные кластеры запросов более точно давали ответы на НЧ запросы за счет наличия значительного числа «поддерживающих» страниц. Заключение Внедрение нейросети BERT в ядро алгоритмов поиска Google - очередной шаг корпорации к улучшению понимания запросов пользователей, заданных на естественном языке. Нейросеть будет развиваться на всех уровнях. Уверен, что она пройдет не только post но pre- тренинг, будет постоянно обучаться, в том числе и силами асессоров, контролирующих качество органической выдачи. Все это скажется в дальнейшем на стратегиях продвижения сайтов и способах манипуляции ранжирующими факторами. И обратите внимание, что русскоязычная языковая модель, по сравнению с англоязычной, на порядок хуже прошла пре-тренинг и показывает гораздо худшие результаты. Это означает, что основные обновления как языковой модели, так и обученной нейросети BERT еще впереди. Готовьтесь и читайте правильную литературу, чтобы понимать, как нужно оптимизировать свой сайт. Источник: DrMax.su |

|||

| 9.4.2019, 1:19 |

LSI ключи: что это, как спарсить и использовать в SEO rush-analytics.ru - блог сервиса SEO-аналитики |

Само собой, это сам запрос, скорее всего. + такие слова как изучение, преподаватель, методика, возможно и т.д. Я не мониторил - просто объясняю суть. Немножко не так. Это скорее будет "школа английского языка" , "курсы иностранного языка" - 'это термины подтверждения, по иному - синонимы или sLSI А изучение, преподавание, методика - это rLSI - релевантные слова. LSI методика требует наличие и тех и других слов в соответствующей (!!!!) пропорции - и это важно! Статью не читал, но заранее порицаю ))) У меня есть старая, но весьма полезная статья, описывающая что такое LSI http://drmax.su/klyuchevye-slova-lsi-algoritm.html ЫЫЫЫ.... Бред полный статья, зря заглянул "В SEO к LSI пришли после того, как Яндекс анонсировал алгоритм “Палех”, который находил слова по cмыслу, используя нейронные связи. " Ничего, что уже лет 5-6 до этого в Google вовсю это LSI использовали? ппц...

|

|||

| 26.2.2019, 21:25 |

Руководство по линкбилдингу 2019 от DrMax drmax.su |

Написал небольшое руководство по современным методам линкбилдинга, оценки анкоров, доменов (в том числе и их токсичности), поиску лучшей стратегии построения ссылочного. Содержание руководства по линкбилдингу: 1. Классификация анкорных текстов ссылок 2. Пример аудита анкор листа лидеров ТОПа 3. Как правильно размещать статью и ссылку в ней 4. По каким параметрам отбирать доноров для линкбилдинга 5. Где брать домены для размещения ссылочного Ответы на вопросы по линкбилдингу Читать полный текст: http://drmax.su/linkbuilding-book.html |

|||

| 28.11.2018, 0:44 |

Закрытие ссылок от поисковых систем методом Post Redirect Get |

||||

| 27.11.2018, 11:20 |

Закрытие ссылок от поисковых систем методом Post Redirect Get |

Метод Post Redirect Get (PRG) относительно прост и дает 100% гарантию закрытия ссылок от поисковых систем. Для этого используется кнопка формы, которую с применением CSS приводим к виду обычной ссылки. Далее: 1. Post - передаем ссылку серверу (в чистом виде, зашифрованную, либо в виде индекса для извлечения URL из базы на сервере) 2. Redirect - браузер от получает от коннектора с сервера URL 3. Get - собственно браузер запрашивает данные новой страницы.  Достоинства способа: 1. Не тратится ссылочный бюджет страницы, как в случае с применением атрибута ссылки Nofollow 2. Работает во всех браузерах, нет необходимости в Java, как в случае с закрытием скриптами 3. Ссылка закрыта от ПС на 100% Недостатки: Собственно переход по PRG-ссылке работает немного медленней, чем просто переход по ссылке. Пример практической реализации PRG- ссылок для WordPress (с исходными кодами) можно посмотреть вот здесь: http://drmax.su/prg-pattern-links.html |

|||

| 24.11.2018, 16:42 |

Восстановление трафика в Google для YMYL сайтов |

С февраля 2017 года Google начал выкатывать обновления, касающиеся качества сайтов. Особое внимание ПС обращает на YMYL сайты - т.е. сайты (и отдельные страницы сайтов) касающиеся здоровья, финансов, репутации и т.д. В 2018 году наибольшее число обновлений Google было связано с подкручиванием алгоритмов, определяющих качество сайтов. В связи со всем этим, у товарищей владеющих финансовыми, медицинскими, ЗОЖ и пр. сайтами зачастую были сильные падения. Особо огорчил всех август - было "вырублено" максимальное число сайтов этих тематик. Итак, если зафиксировано падение Google-трафика в следующие даты:

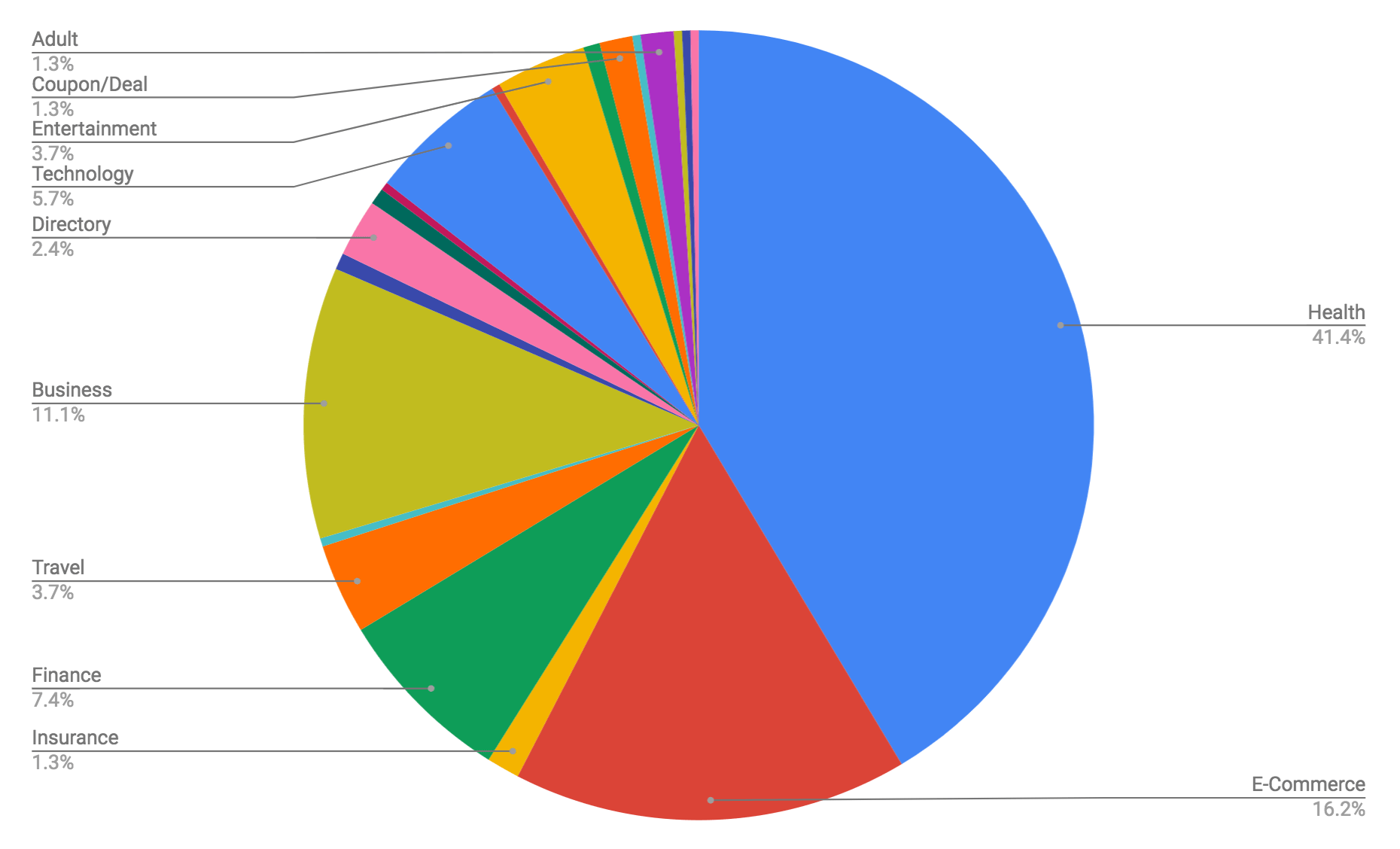

, то скорее всего это связано с недостатком качества вашего YMYL сайта. И статья предназначена именно для вас. Так получилось, что несколько месяцев подряд занимаюсь анализом качества пострадавших сайтов и поиска пути восстановления трафика. На сегодняшний день трафик для примерно 60% сайтов удалось восстановить, для 20% - улучшить. Все рекомендации изложил в виде пошаговой инструкции по совершенствованию качества сайта: "15 шагов по улучшению качества сайта". Обратите внимание, что инструкции хорошо коррелируют с новой редакцией руководства Google для асессоров по оценке качества. Ниже приведена сравнительная диаграмма, кого именно затронуло августовское обновление качества Google:  А как обстоят дела у ваших YMYL сайтов с трафиком в Google? |

|||

| 5.5.2018, 18:48 |

Mobile-First Index – убийца оптимизаторов от Google Уже совсем скоро многие сайты просядут в выдаче. С чем это связано? |

VadymO, при чем тут AMP? Плюнуть на них и растереть - они пока только для информационников. Суть этого Mobile-first индекса в том, что для кэша гугла, который у них един и для десктопа и для мобайла, теперь будет браться мобайловая версия, а не десктопная. Если мобильной версии нет - то будет запихиваться десктопная в кэш. А это сразу минусы по факторам ранжирования. Мобильная же версия - суть не копия десктопной. см исследование мозовское на которое я дал ссылки. В целом, вот накатал статейку еще одну, как готовиться к этому Mobile-first индексу: http://drmax.su/6-step-google-mobile-first.html P.S. 70% сайтов, судя по замерам, к нему не готовы от слова совсем. |

|||

| 25.4.2018, 22:39 |

Mobile-First Index – убийца оптимизаторов от Google Уже совсем скоро многие сайты просядут в выдаче. С чем это связано? |

Совсем скоро значительное число SEO оптимизаторов, долгое время продвигающие клиентские сайты, понесут заслуженную анальную кару от своих заказчиков. На наших глазах продолжается первый акт интереснейшего действия, который может отбросить далеко за ТОП мощнейшие сайты, десятилетиями просиживающими в ТОПе. И все это связано с постепенным разворачиванием Mobile-first индекса Google. Итак, приступаем. 26 марта 2018 года Google заявил о поэтапном развертывании Mobile-First Index. Что это такое? Индексирование Mobile-first означает, что Google будет использовать мобильную версию страниц сайта для индексирования и ранжирования. У них есть только один индекс, на основе которого вычисляются факторы ранжирования и строится органическая выдача поисковой системы. Если ранее индекс строился на основе десктопной версии сайта, то теперь будет строится на основе мобильной версии (если это возможно). Я поговорил со многими знакомыми оптимизаторами, как буржуйскими, так и нашими. Так вот, если у первых потихоньку вызревает паника и они судоржно принимают меры, то наши, доморощенные оптимизаторы, даже не чешутся. “У нас же есть респонсивная (адаптивная) версия сайта. Там все красиво. Чего еще нужно?” – так мне ответили многие товарищи. Ну что же, давайте посмотрим чем это грозит подавляющему большинству сайтов. Смерть части ссылок Как ни крути, ссылочное – это важнейший фактор ранжирования на сегодняшний день. Если сайты массово потеряют ссылочное, то это, безусловно, скажется на их позициях в поисковой выдаче. Теперь данные свежего исследования от MOZ. При внедрении Mobile-first индекса – вы потеряете более 60% ссылок. Это связано как с организацией мобильных версий страниц, так и с особенностями обхода пауками (краулерами) мобильной версии сайта. Ну например организация архива в виде “ленивой загрузки” (lazzy loading) может привести к тому, что часть материалов выпадет из индекса или никогда не проиндексируется, даже, не смотря на карту сайта. Если она и проиндексируется, то из-за отсутствия ссылок (кроме карты сайта), вес страницы будет минимальным, соответственно, передаваемый ссылкой вес будет стремиться к нулю. Особенно попадут под удар старые ссылки, наиболее жирные, позволяющие быть в ТОПах годами, не смотря на все изменения ранжирования. Кроме того, мобильная версия сайтов и десктопная различаются и меню и перелинковкой. Произойдет сильнейшая переоценка весов внутренних страниц, соответственно, снизится вес внешней ссылки, отдаваемой донором. Опять таки, здесь более всего пострадают старые ссылки. Из -за ошибок в мобильных версиях сайтов, которые большинство толком не оттестировали, только натянув адаптивный шаблон, многие страницы мобильной версии сайта, даже в случае их индексации, не получат никакого веса и выпадут (скорее всего) из выдачи.  Здесь оранжевый цвет – уникальные ссылки для десктопной версии, синий – уникальные внешние для мобильных версий страниц, серые – общие для обеих версий. Исследование проведено на основании выборки и анализа мобильных и десктопных версий 20000 произвольно выбранных сайтов. Как мы видим, по данным исследования, в мобильной версии сайтов было утеряно 63% внешних ссылок. Как вы думаете, при глобальном переходе на Mobile-first индекс это скажется на ранжировании? Или беспокоиться не о чем? Скорость рулит Уже с июля этого года, скорость работы сайта станет официальным фактором ранжирования. Все это так-же связано с внедрением Mobile-first индекса. Выигрывать будут быстрые, оптимизированные сайты, использующие SSL сертификаты и работающие на протоколе HTTP/2. Кроме непосредственного влияния этого фактора на ваш сайт (а вы уже внедрили все рекомендации Google по оптимизации скорости работы?), это скажется на массе сайтов, которые и не подумают ничего подобного внедрять. Как правило это старые сайты, ссылки с которых до сего дня имели хороший вес. Теперь, из за падения их рейтинга, их положение в органике ухудшиться, что приведет к снижению их траста. Таким образом, если вы имеете ссылки на старых сайтах, которые не будут оптимизировать скорость работы, то вес их значительно упадет. И все это добавиться к тем 63% ссылок, которые просто не будут учитываться. Как вы думаете, стоит ли заняться оптимизацией своего сайта и увеличить его скорость? Уже сегодня в некоторых темах я вижу появление в ТОПе прямо говоря говносайты, но использующие CDN и массу дешевых, но свежих ссылок. Хоть их быстро вычищают, но можно уже предположить,как в самом ближайшем будущем будет перераспределен ТОП. За что еще будут наказаны оптимизаторы и сайты Внедрение Mobile-first индекса принесет еще море горя оптимизаторам. Ну например, есть три варианта организации мобильной версии сайта, один из которых на поддомене. Исторически это m.site.ru/. Вот эти то товарищи хапнут проблем. Во-первых пока непонятно, будет ли Google считать мобильную версию m.site.ru за основную для site.ru, будет ли он пихать его в кэш или это два отдельных сайта (что вроде бы логично). Тогда для основного сайта не будет мобильного кэша, траст такого сайта упадет. Или как быть с каноническими страницами. Какие из них теперь важнее мобильные или десктопные. Во-вторых, качество ссылок с таких сайтов неизбежно рухнет. А это, как правило, старые и трастовые сайты, внедрившие мобильные версии одними из первых. И если ссылки с них были раньше предел мечтаний, то теперь они обесценятся. В третьих и для самих владельцев таких сайтов тоже наступит горе. Если Google признает главной страницу m.site.ru и на основе её будет рассчитывать факторы ранжирования, то ссылочное на эти m.site.ru будет практически нулевым. Следовательно, им придется начинать все продвижение с самого начала. Если главным и кэшируемым будет site.ru, то ждите санкций за отсутствие мобильной версии и адаптации под мобильный. Повезло владельцам адаптивных сайтов – им не придется решать вышеуказанные проблемы. У них будут свои. Ну например отсутствие SSL сертификата. Как вы знаете уже летом все сайты без него будут помечаться в браузере как ненадежные и ранжирование этих сайтов будет на порядок хуже (см например статью Голосовой поиск и SEO оптимизация сайта под него в 2018 году). Или скорость сайта. Сможет ли ваш сайт побороться с AMP страницами, которые загружаются за доли секунды? Неверно выстроенная линкбилдинг стратегия, ориентация на неверные факторы ранжирования – все это с введением Mobile-First индекса приведет к сильным тряскам в органической выдаче. Совсем скоро мы увидим как рухнут позиции старых сайтов и на их место выйдут новые, молодые, оптимизированные проекты, отвечающие требованиям по качеству поисковых систем. Кто виноват и что же делать? Google призывает нас не паниковать – мол изменения в индексе будут незначительными. Действительно, с точки зрения поисковых систем общая просадка ссылочного, в среднем, должно повлиять одинаково на все сайты. Но вам то не будет легче, если ваш сайт улетит даже за ТОП 10. Советы весьма просты:

Еще больше подробностей я планирую выложить в виде цикла статей по отдельным приемам оптимизации мобильной версии сайта. На сайте есть и учебник, который я недавно написал, по работе с мобильными версиями сайтов. А что делаете Вы для подготовки к Mobile-first индексу ?  Источник: http://drmax.su/mobile-first-index.html |

|||

| 19.3.2018, 11:21 |

Голосовой поиск и SEO оптимизация сайта под него в 2018 году |

Голосовой поиск – это наименее изученная область в SEO оптимизации сайтов. И это очень удивительно. На сегодняшний день более 50% запросов в ПС поступает с мобильных устройств. При этом около 20% этих запросов составляют именно запросы, задаваемые голосом. Следовательно, как минимум 10% всех запросов к Поисковым системам – это именно голосовые запросы. Тенденция развития мобильных платформ указывает на то, что через три года более половины запросов будут задаваться именно голосом. Следовательно, уже сейчас нужно стремиться к тому, чтобы понять, какие именно факторы оказывают влияние на результаты голосового поиска и как можно доминировать в результатах выдачи голосового поиска. Оптимизация сайта под голосовой поиск является трендом 2018 года. Ведущие мировые оптимизаторы сегодня проводят исследования, пытаясь выделить наиболее важные факторы ранжирования в голосовом поиске. Резюмируя наиболее интересные факты, можно проанализировать корреляцию отдельных факторов с результатами голосового поиска. Факторы оказывающие влияние на ранжирование в голосовом поиске На выборке в 10000 запросов исследователи выявили такие коррелирующие друг с другом закономерности:

Давайте рассмотрим подробно предложенные корреляции и предположим, как можно оптимизировать сайты наилучшим образом под голосовой поиск. Источник: http://drmax.su/voice-search-seo-2018.html |

|||

| 16.11.2017, 12:39 |

Факторы ранжирования 2018 (по версии SEMrush) |

Перевел отличное исследование от SEMrush, дополнил их своими замечаниями. Довольно необычные получились результаты, например наблюдается сильная корреляция между директ-трафиком (прямыми заходами) и позициями в выдаче, при этом наличие ключей в разных местах (тайтл, статья, дескрипшен) показали значительно меньшее влияние. Читайте полный текст исследования факторов ранжирования  |

|||

| 13.10.2017, 12:38 |

Ключевые слова в эпоху LSI алгоритмов |

LSI тексты — это контент, релевантный намерению пользователя, а не ключевым словам. Он состоит из однородных контент-единиц (абзацев, разделов, статей или глав), широко раскрывающих как основную так и смежные темы. Релевантность контента намерению пользователя определяется синхронным наличием в тематической области устойчивых терминов (терминов подтверждений) и релевантных тематике терминов. Статья описывает технику сбора ключей (ключевых слов) как для контента, так и линкбилдинга. Из-за обилия графических материалов, статью сюда запостить сложно. Читайте пожалуйста на источнике. Это первая часть статьи, в ней упор сделан на работу с SemRush. При желании можно написать продолжение про исследования ключей в Гугловском "Плаировщике", использованием всяких сервисов и программулек. Также осветить проблему структуризации ключей при большой выборке, проблему каннибализации и пр. |

|||

| 4.10.2017, 10:19 |

10 факторов не влияющих на ранжирование в Google |

На днях, в своей новой Whiteboard Friday, знаменитый оптимизатор и знаток SEO Рэнд Фишкин высказал ряд «крамольных» с точки зрения рядовых сеошников мнений. Я постараюсь кратко довести его высказывания до вас (своими словами) и пояснить собственными комментариями. 1. Возраст вашего сайта Отдает ли Google предпочтение сайту, зарегестрированному в 1998, 2008 или 2016 году? Нет, поисковой системе безразлична дата регистрации. Она отслеживает исключительно степень полезности контента конечным пользователям и SEO сигналы. Естественно, если вы запустили сайт в 1998 году и поддерживаете его актуальным до сих пор, есть шансы, что на него построено множество сильных ссылок, вокруг сайта сложилась постоянная аудитория, порождающая активные SEO сигналы. Тогда сайт будет прекрасно ранжироваться. Однако, есть вариант, что вы создали сайт 2 года назад и получили все те же ссылки и аудиторию. Тогда Google, скорее всего, предпочтет «новый» сайт, потому что он заработал такой же авторитет, что и старый сайт, за более короткое время. 2. Использование приложений и служб от Google Зачастую товарищи беспокоятся, что Google может отслеживать и сопоставлять происходящее в Google Analytics, AdSense, просматривать почту в Gmail и документы в Google Docs. На самом деле это не так. Если вы используете почту для переговоров о покупке ссылочного, это никак не повлияет на ранжирование связанного с вами сайта. Не смотря на то что ваш сайт не так авторитетен, как кажется, Google до этого дела нет. 3. Использование счетчиков лайков, шар, +1, твитов предположим у вас стоит счетчик от Facebook и он показывает 17000 шар. Это очень много. Обращает ли на это внимание Google? Нет, им все равно. Фактически они не смотрят на это и никак не используют. Если люди, расшарившие вашу новость проявляют социальную активность, переходят по ссылкам (на ваш сайт), ищут информацию (о вас), косвенно продвигают ваш бренд, тогда, опосредовано, будет заметно влияние социальных сетей на ваши позиции в серпе. Если вы просто купите 10000 шар ботами, то никакого влияния не будет. 4. Показатель отказов и время проведенное на сайте Предположим, что посетитель в среднем проводит на сайте 2 минуты. Вы смотрите средние показатели в тематике, предположим через Google Analytics и видите что ваш показатель ниже среднего. Это скажется на ранжировании? Вовсе не обязательно. Возможно пользователи пришли не с выдачи, а из другого места. Возможно ваш сайт работает быстрей чем в среднем по отрасли и посетитель получает необходимую информацию более быстро, поэтому и время проведенное на сайте ниже и, возможно, показатель отказов выше. Если люди не возвращаются к серпу (выдаче поисковой системы) и не выбирают другой результат, потому что вы на сайте не ответили на их запросы, все остается в порядке.Таким образом, просто показатель отказов и время проведенное на сайте, не увязанные с другими факторами, довольно малоинформативны и не вызывают особого беспокойства. 5. Технологии, используемые на сайте Используете ли вы на сайте JavaScript библиотеки от Google или от Facebook, применяете ли для создания кода .NET или чистый HTML, для Google это не имеет значение. Если Google может получить URL-адрес и увидеть там уникальный контент, при этом контент, который видит Google, и который видят посетители сайта одинаковы, поисковику все равно, что вы используете на сайте, чтобы отреендерить это в браузер. 6. Наличие или отсутствие панели знаний в правой части результатов поиска Иногда вы видите справа в выдаче панель знаний. На ней показана информация собранная с сайтов и с Википедии. Когда вы ищите свой бренд, вы можете видеть данные о компании на панели знаний. Это влияет на ранжирование сайта? Нет. Для любого другого поискового запроса никаких преимуществ вы не получите. То что компания появилась на панели знаний позволит получить значительное число переходов с выдачи по бренд-запросу. Но любой не связанный с брендом запрос ранжироваться лучше не станет. 7. Использование общедоступного или недорогого хостинга Прямо это не влияет на ранжирование, если это не сказывается на скорости загрузки сайта. Если время загрузки сайта также мало, как при использовании платного хостинга или выделенного сервера, то все в порядке. 8. Использование мета-тэгов, для установки уже предполагаемых значений по умолчанию. Когда сканер Google приходит на ваш сайт и у вас нет robots.txt или он пустой, то паук по умолчанию обходит все доступные страницы, переходя по ссылкам. Используя такие штуки как «index, follow» в мета-тэгах страницы, либо в каждой ссылке прописывая rel=follow, показывая пауку Google что он может это просканировать, вы ничего не добиваетесь. Это не повредит вам, но и не приносит никакой пользы. Google это просто не волнует. 9. Символы, используемые в качестве разделителей в теге title. Тэг title отображается в заголовке документа, и это может быть что-то вроде вашего фирменного наименования, а затем разделитель и некоторые слова и фразы после него, или наоборот, слова и фразы, разделитель, фирменное наименование. Имеет ли какое-то значение, что этот разделитель является символом «дефис», «вертикальная черта» или «двоеточие» либо другой специальный символ? Нет, Гуглу все равно. Вам не нужно беспокоиться об этом. Это вопрос личных предпочтений. Однако, возможно, вы обнаружили, что один из этих символов имеет немного больший CTR в выдаче, чем другой. Если вы обнаружили и используете его — вам повезло. Однако мы не видели широкого распространения этого в Интернете. 10. Использование заголовков и тегов H1, H2, H3? Если вы помещаете заголовок внутри H2, а не в H1, будет-ли Google считать это немного менее важным. Нет, это определенно не так. На самом деле, я даже не уверен, в какой степени Google вообще заботится о том, используете ли вы H1 или H2 или H3, или они просто смотрят на контент, и они говорят: «Ну, это большой текст, расположен сверху и выделен жирным шрифтом. Это должно быть заголовок и именно так мы будем относиться к нему. Ну а этот расположен ниже и меньше. Это, вероятно, подзаголовок. Таким образом нет никакой разницы, что вы используете в виде заголовка H5 или H2 или H3, это все решается стилями вашего CSS на сайте. Конечно, лучше всего использовать HTML-код, чтобы главный заголовок (самый крупный) был H1. Я сделал бы это и для дизайна и для того, чтобы иметь валидный и чистый HTML код и CSS, но я бы не стал подчеркивать важность этого с точки зрения Google. Если ваши дизайнеры скажут вам: «Эй, мы не можем использовать заголовок в H1. Мы должны использовать H2 для заголовка. Хорошо. Ничего страшного не произошло. -------------------------------- На этом статья Рэнда заканчивается. Я дополнил её своими комментариями и привел еще десяток SEO факторов у себя на сайте, которые непосредственно не влияют на ранжирование в органической выдаче. Желаю удачи. тов. DrMax |

|||

| 11.7.2017, 7:24 |

Требования к донору |

Буду благодарен за список. Уверен многим пригодится. Зимой еще написал такую статью "Как отобрать донора"... даже с видео Упор сделан на скорость и качество отбора донора Исследуется величина и качество трафика донора + отсутствие его "продажности". Тематика при продвижении статьями - не важна. Нужно уметь просто вписывать свои статьи в любую тематику и служить прокладкой между донором и акцептором. вобщем вот : http://drmax.su/backlinks-analiz-kachestva.html/ |

|||

| 6.7.2017, 10:14 |

[Книга] SEO ГУРУ 2017: Техника внутренней перелинковки Бесплатный мануал по внутренней перелинковке |

День добрый, друзья. Выложили новую книжку по технике внутренней перелинковки. Хотелось бы её обсудить. Основные мысли в книге таковы (при условии рассмотрения сферического сайта в вакууме - без внешних ссылок): 1. В узком смысле, внутренняя перелинковка есть процесс перераспределения веса от «малозначащих» страниц к более «значимым». 2. Общий (суммарный) вес страниц сайта не зависит от внутренней перелинковки: 2.1. Суммарный вес всего сайта (без учета внешних факторов) никогда не вырастет от наличия внутренних ссылок, вне зависимости от применения схем линковки. 2.2. Суммарный вес сайта может значительно снизится при наличии «битых» ссылок, ссылок на страницы закрытых от индексации, дублирующихся ссылок на одну и туже страницу со страницы- донора, ссылок, закрытых в теги «nofollow», технических ссылок на скрипты, ссылок на изображения и пр. 3. В широком смысле, цель перелинковки – увеличение «удобства» конечного пользователя сайта и удовлетворение его потребностей. 4. В узком смысле – перелинковка необходима для демонстрации Поисковым Системам (ПС) наиболее значимых страниц. 5. Вес страниц является абстрактным понятием и складывается из суммы весов ведущих на страницу ссылок: 5.1. Страница, не имеющая внутренних ссылок-доноров, не будет ранжироваться в Поисковых Системах (ПС) из-за отсутствия веса. 5.2. Поскольку внутренние ссылки, в большинстве своем, являются анкорными, суммарный вес страницы является абстрактным, неоднородным и складывается из составляющих весов именно анкоров ссылок. Так, даже значимая страница сайта, будет хорошо ранжироваться по анкорам внутренних ссылок-доноров с большим весом и плохо по анкорам ссылок-доноров с минимальным весом. 6. При наличии двух и более ссылок с одной страницы на одинаковую страницу – донор, учитываться и передавать вес будет только одна. Выбор значимой ссылки производится ПС и влияние на этот выбор пользователем – незначительное. 6.1. При наличии дублирующихся ссылок со страницы-донора на страницу-акцептор, общий суммарный вес сайта (всех страниц) будет снижаться. 6.2. Избежать ссылок-дублей можно закрытием повторов ссылок в скрипты. 7. Вес каждой исходящей ссылки с одной страницы изначально одинаков (при первой индексации страницы). 7.1. Изначально, вес каждой исходящей ссылки равен рассчитанному весу страницы, уменьшенному на коэффициент затухания, деленному на число ссылок. 7.2. Вес каждой ссылки может принудительно снижаться при отсутствии переходов по ним. 7.3. Отсюда, наибольшим весом, через несколько итераций перерасчетов весов, будут обладать ссылки, наиболее доступные для пользователя – т.е. расположенные выше в контексте. 7.4. Отсюда же, недопустимо делать ссылки, не выделенные в контексте, по которым пользователь не сможет сделать переход. 7.5. Отсюда же, число контекстных ссылок на странице должно быть конечным и не слишком значительным. 7.6. Обновление информации на странице контекста может сбросить коэффициент снижения веса ссылки и страницы (см п.9.). 8. Значительное дублирование анкоров ссылок в пределах сайта может привести к наложению штрафов на страницу – акцептор. Исключение могут составлять перекрестные ссылки (меню и подменю). 8.1. Анкоры ссылок в меню учитываются. Вес перекрестных ссылок может быть снижен или полностью не учитываться. 8.2. На основании п.7.1. и п.8.1. из – за ссылок в меню может происходить утекание суммарного веса сайта. 8.3. Наличие обширного структуризированного меню, дублирующегося на каждой странице сайта – не желательно. 9. Обновление контента на старой странице может приводить к сбрасыванию коэффицентов снижения веса исходящих ссылок. 9.1. При внедрении контекстной внутренней перелинковки со старых страниц необходимо ставить ссылку в новом, свежем абзаце. 9.2. Анкоры ссылок необходимо делать 2-3 словными, описательными, без значительных дублей в пределах сайта. 9.3. Поскольку современные ПС производят одномоментное вычисление конечных весов страниц путем построения графа, где вершинами являются веса страниц а набор ребер – вес ссылок, то обновление информации на сайте может приводить к восстановлению суммарного веса страниц всего сайта. 9.4. Внутренняя перелинковка лучше работает на крупных, обновляемых проектах. Скачать мануал по внутренней перелинковке можно на офф сайте. Там же содержание, отзывы и прочие материалы к этому мануалу. |

|||

| 8.4.2013, 13:43 |

Content Monster II система генерации сайтов |

Content Monster II - система быстрой верстки сайтов любой степени сложности. Официальный сайт: http://content-monster.com/ =========================================== Тема является продолжением этой темы. =========================================== Доступен для обновления релиз 1.3.0. Среди множества изменений, наиболее интересным является вторая версия полуавтоматического профессионального рерайтера с полной поддержкой морфологии и расширенным тезарусом. Список изменений версии:

Как всегда, обновляйтесь в клиентской зоне на официальном сайте |

|||

| 26.10.2012, 14:34 |

Продам постовые ТИЦ 30, Pr 2, посетители 500+ |

Разместился на сайте. Очень понравилась оперативность размещения и качество самого проекта. Крайне признателен. |

|||

| 26.7.2012, 11:23 |

Вышел первый релиз CM2 TreeEdit Content Monster II - платформа создания и продвижения веб проектов |

Одна из последних - тут http://blap.ru/2012/07/sell-2012/ |

|||

| 25.7.2012, 19:56 |

SEO Монстр 2012 руководство для оптимизаторов |

Представляем Вашему вниманию руководство SEO Монстр 2012 от Blap.Ru Содержание: Предисловие от 3 издания SEO Монстра 4 Введение в SEO оптимизацию 2012 12 Раздел 1. Внутренняя оптимизация сайта 14 1.1. Эффективность сайта – как показатель качества ресурса 14 1.2. Проектирование и оптимизация урлов сайта 17 1.3. Проектирование и оптимизация сниппетов 20 1.3.1. Манипуляция со снипеттами (продолжение) 25 1.4. Структура сайта – страницы и новости 27 1.4.1. «Продающие» страницы. Основы. 29 1.4.2. «Продающие» страницы. Некоторые секреты. 30 1.5. Правила внутренней перелинковки 32 1.6. Оптимизация меню 34 1.7. Юзабилити сайта 36 1.7.1. Введение в юзабилити 36 1.7.2. Чек лист самостоятельной оценки юзабельности сайта 38 1.8. Внутренняя перелинковка 40 1.8.1. Общепринятые технологии внутренней перелинковки 40 1.8.2. Внутренняя перелинковка – некоторые частные приемы 44 1.9. Работа с изображениями 47 1.10. Оптимизация макета сайта 58 Раздел 2. Работа с семантическим ядром 59 2.1. Введение в работу с семантическим ядром 59 2.2. Пример выбора тематики и SEO разведки 62 2.3. Составление семантического ядра 70 2.4 Техники разбавления анкоров 77 2.4. Манипулирование брендом в целях наращивания траста 80 2.5. Анкорные группы в эпоху фильтра «Пингвин» от Гугла 81 Раздел 3. Стратегии продвижения 2012 года 82 3.1. Продвижение контентом и основанным на нем ссылочным 82 3.2. Контент + Мощное Внутреннее Ссылочное 89 1.3. Контент + Социальные сигналы 92 1.4. Создание мощных страниц списков 96 1.5. Увеличение авторитета домена через брендинг и привязывание авторства 99 3.6. Стратегия микроформатов 102 3.7. Стратегия ссылочной пирамиды 103 3.8. Практические приемы по улучшению качества сайта 105 Раздел 4. Агрессивные техники продвижения 107 4.1. Правила вывода ключа в ТОП для Гугла 107 4.2. Повышаем траст сайта и выдергиваем ключи в ТОПы 110 4.3. Тотальная доминация в серпе 114 4.4. Скупка трафика и траста контентом 116 4.5. Доминация сателлитами 117 Раздел 5. Теория SEO 2012 118 5.1. Важнейшие метрики страницы и сайта 118 5.2. SEO стратегии 2012 121 Раздел 6. Продвинутые методы белого продвижения 124 6.1. Теория белого продвижения 2012 124 6.2. Продвижение релевантными блогами 126 7. Выход из под фильтров 127 7.1. Стратегии улучшения качества сайта и выход из под Панды 127 7.2. Выход из под фильтра Пингвин от Google 132 Руководство доступно для скачивания на официальном сайте blap.ru в течении ближайшей недели. С уважением, DrMax и sNOa |

|||

| 16.1.2012, 16:58 |

Как щелкнуть панду по носу выход из под фильтра Панды |

Расписал теорию и практику вывода одного проекта из под фильтра Панда. Привел рекомендации по аудиту сайта. Опроверг мнение буржуйских "Гуру" о трудности выхода из под оного фильтра. Ознакомиться здесь:было тут |

|||

| 13.12.2011, 14:51 |

Вышел первый релиз CM2 TreeEdit Content Monster II - платформа создания и продвижения веб проектов |

Подготовили кучу Новогодних подарков. Получить их можно здесь: http://blap.ru/2011/12/novogodnie-podarki-ot-blap-ru/  |

|||

| 6.11.2011, 20:36 |

SapeDroid Клиент Sape для Андроида |

Небольшая утилита для снятия статистики Sape на гаджетах c Андроидом 2.1 и выше  Вывод детальной информации по сайту  В следующих версиях планируется виджет на рабочий стол, автоматическое обновление, добавление в маркет. Скачать SapeDroid: http://blap.ru Вопросы и пожелания можно задавать непосредственно тов sNOa на форуме |

|||

| 11.6.2011, 20:05 | У вас нет прав на просмотр этой темы | У вас нет прав на просмотр этого сообщения |

|||

| 16.5.2011, 21:00 |

Удар серпом по ... сапе итоги экспериментов |

Все правильно и в Яндексе такая же картина. ПС любят ссылки в новом контенте и на мордах Интересное замечание для гугла.... Например новая ссылка с необновляемой и уже проиндексированной морды практически не передает веса. Опробировано на контрольных закупках оных. По яндексу - думаю подтянется вслед за гуглом. |

|||

| 16.5.2011, 20:08 |

Удар серпом по ... сапе итоги экспериментов |

Подведение итогов эксперимента по оценке веса ссылочного из проиндексированных статей, свежих статей (размещение ссылки до публикации) и сквозняков. http://lipf.ru/udar-serpom-po-sape.html |

|||

| 30.4.2011, 18:13 |

Вышел первый релиз CM2 TreeEdit Content Monster II - платформа создания и продвижения веб проектов |

||||

1 2 >

1 2 >

|

Текстовая версия | Сейчас: 24.4.2024, 9:53 |